За wordpress правилен файл

Здравейте мили приятели!

Сега ще напиша статия за сензационния файл, от който толкова се страхуват младите собственици на сайтове. И не напразно, защото ако се състави неправилно, могат да възникнат лоши последици.

Предметът на статията е файлът robots.txt. Днес ще анализираме от основите на компилирането му до пример за моя личен файл, който в момента работи добре. Материалът се оказа доста сложен и след първия прочит може да не добиете впечатление за пълна картина, но трябва да уловите основната идея. Ще има много съвети и вътрешна информация, които да ви помогнат да подобрите индексирането на вашия сайт.

Преди да компилирате сайт, силно препоръчвам да се запознаете с най-важните аспекти на работата на файла robots. Трябва да разберете поне основните принципи на това как работят роботите на търсачките, за да разберете какво и как трябва да бъде затворено от индексиране.

Важна теория

Първо, дефиницията на самия файл.

Файлът Robots.txt дава на търсачките разбиране какво не трябва да се индексира на сайта, за да се предотврати появата на дублирано съдържание. Можете да затворите цели секции, отделни страници, папки на хостинг и т.н. от индексиране. Всичко, което ви хрумне.

Това е този файл, на който търсещите роботи обръщат първо внимание, когато влизат в сайта, за да разберат къде да търсят и какво трябва да се игнорира и да не се въвежда в базата за търсене.

Освен това този файл служи за улесняване на работата на роботите за търсене, така че да не индексират много страници за боклук. Това създава натоварване на нашия сайт, тъй като роботите ще се изкачват дълго време в процеса на индексиране.

Много е важно да разберете, че за някои сайтове файлът може да се различава, така чеКак може да има сложна структура. Но основната идея е да затворите страници, които са генерирани от самия двигател и да създадете дублирано съдържание. Освен това задачата е да се предотврати попадането на такива страници в индекса, а не само тяхното съдържание. Ако имате прост WordPress сайт, тогава файлът ще ви подхожда.

Също така препоръчвам да се задълбочите във всичко и да се опитате да разберете тънкостите, тъй като това са моментите, които могат постепенно да унищожат ресурса.

След това си струва да разберете как търсачките се отнасят към този файл, тъй като Yandex и Google имат разлики във възприемането на забраните, които са написани в роботите.

Разлики в работата за Yandex и Google

Единствената и може би съществена разлика е, че Yandex възприема забраните във файла като вид задължително правило и спазва всички забрани доста добре. Казахме му, че не е необходимо да въвеждаме тези страници в индекса и той не ги взема.

Превежда се по следния начин: „Описанието на уеб страницата не е достъпно поради ограничение в robots.txt.“

Колкото и лошо да е. Но след това страницата влезе в индекса, въпреки че нямаше дублиране. Като цяло може да бъде, но можете напълно да се отървете от такъв боклук.

И тук има няколко решения:

В резултат на това има 2 настройки, които няма да ви позволят да събирате боклук в индекса. Но това е при условие, че такива страници са отворени във файла robots и Google има пълен достъп до тях;

Като цяло нетова се случи, струва си да използвате правилния файл без ненужни забрани + отворете всички подобни страници за търсачката на Google.

Лично аз направих точно това. Имам всичко затворено със скрипт и пренасочвания.

Преди да разгледаме основите на правилния robots файл, нека да разгледаме основните директиви, така че на основно ниво да разберете как се компилира този файл и как може да бъде модифициран, за да отговаря на вашите нужди.

Основни директиви

Основните директиви на файла robots са:

-

User-agent - директива, която указва към кой робот на търсачката принадлежат правилата за забрани и разрешения. Ако правилата трябва да бъдат присвоени на всички търсачки, тогава след директивата се поставя звездичка *, но ако си струва да регистрирате правилата за конкретен робот, например Yandex, тогава си струва да регистрирате името на робота. В този случай директивата ще бъде написана така:

Име на други роботи:

В този случай директорията "inter", както и всичко в нея, ще бъде забранено за индексиране; Allow - директива за разрешаване на индексиране на части от сайта. Ако трябва да разрешите някаква част, тогава, по аналогия с директивата Disallow, предписва името на директорията или отделна страница. Например, ако трябва да отворя подраздела „pr“ в директорията „inter“, тогава правилото ще бъде написано така:

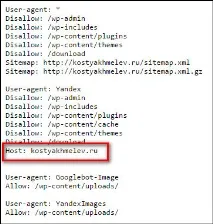

Въпреки че затворихме директорията "inter" в предишния случай, подразделът "pr" ще бъде индексиран и всичко в него също ще бъде достъпно за роботи за търсене. Хост - директивата е предназначена да посочи на търсещите роботи основното огледало на сайта (с или без www).

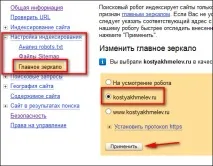

Струва си да се регистрирате само в Yandex. Също така трябва да посочите основния огледален сайт в панела за уеб администратори на Yandex.

Важно! Всяка директива трябва да има отстъп с един интервал.

Познавайки основните моменти в работата на robots.txt и основните принципи на неговото компилиране, можете да започнете да го изграждате.

Компилиране на правилния файл

Като цяло, идеалният вариант би бил напълно да отворите сайта си за индексиране и да позволите на роботите за търсене сами да разберат цялата ситуация. Но техните алгоритми не са съвършени и те вземат в индекса всичко, което може да се вземе само в базата за търсене. И нямаме нужда от това, тъй като ще има много дублирано съдържание в сайта и много страници за боклук.

За да предотвратите това, трябва да създадете файл, който ще позволява да се индексират само страниците на самите статии, тоест съдържанието и, ако е необходимо, страницата, ако носят полезна информация за посетителя и търсачките.

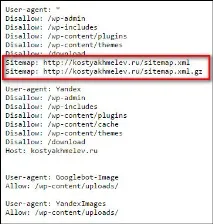

Въз основа на това направих файл, който отваря целия сайт за търсачката на Google (с изключение на служебните директории на самата машина на WordPress) и затваря всички дублирани страници от Yandex, Mail и други търсачки.