Изкуственият интелект на Google се научава да говори красиво китайски и английски

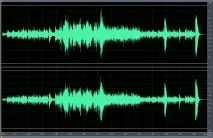

За да направи това, една самообучаваща се невронна мрежа трябва да слуша много аудиозаписи и да се научи как самостоятелно да подчертава смислообразуващите промени в дължината на звуковата вълна. Това обаче не е толкова лесно. Аудиозапис на човешка реч е около 16 000 звукови модулации в секунда. Представете си визуализация на звукова вълна - правилна вретенова графика. Всяко огъване на това вретено се генерира от хиляди промени в дължината и амплитудата на звуковата вълна.

Съществуващите генератори на реч работят чрез конкатениране (слепване) на фрагменти от записана реч от обширна библиотека. Техният звук не е трудно да се различи от човешката реч. Често чувате конкатенативен TTS (text-t-speach systems) в навигацията: „Завийте надясно, след това завийте надясно“. Без допълнително записване на огромни библиотеки е невъзможно да се постигне естествено звучене от такава система. Следователно имаше нужда от параметричен TTS (като тези, които съществуват във вокодерите), който можеше да озвучи всеки фрагмент от текст, който не беше известен предварително, и в същото време да бъде неразличим на ухо от речта на жив човек.

WaveNet ще работи като параметричен синтезатор на реч. При параметричния подход речта се разлага на набор от непрекъснато променящи се сигнали. Досега параметричните системи можеха да възпроизвеждат само кратки съобщения, известни предварително, но WaveNet ще може да предвиди параметрите на всяко следващо трептене благодарение на същата архитектура на невронна мрежа, която позволи на Deep Mind да се научи да разпознава изображения. Прогнозата за всеки нов параметър ще се основава на опита от всички минали прогнози на невронната мрежа, следователно, докато невронната мрежа се учинейните способности ще растат експоненциално.

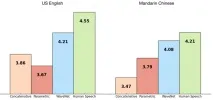

По време на обучението в компютъра се зареждат записи на речта на живи хора на английски и китайски. След обучението разработчиците искат WaveNet да изрази генерираните от себе си фрази. Това, което системата издава сега, все още е различно от речта на жив човек, но вече не звучи като изкуствен глас от навигатор.

Преди това Deep Mind победи човек в Go и разработи алгоритъм за офталмологична диагностика.