Как да затворите съдържание от ръководството за индексиране

Понякога възникват ситуации, когато трябва да затворите част от съдържанието от индексиране. Нека да разгледаме примерите по-долу.

Често необходими неща, които трябва да бъдат скрити от индексиране от Yandex и Google:

- Скрийте техническата информация от търсенето

- Затваряне от индексиране на неуникално съдържание

- Скриване на напречно, повтарящо се в сайта съдържание

- Затворете нежеланите страници, от които потребителите се нуждаят, но за робота изглеждат като дубликат

Как да затворите домейн и поддомейн от индексиране

За да затворите домейн от индексиране, можете да използвате

1.Robots.txt

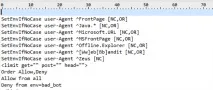

За да направите това, ние пишем следните редове в него:

С помощта на тази манипулация затваряме сайта от индексиране от всички търсачки.

Ако трябва да затворите от индексиране от конкретна търсачка, можете да добавите подобен код, но като посочите UserAgent.

Понякога, напротив, е необходимо да се отвори само конкретен PS за индексиране. В този случай трябва да компилирате файла Robots.txt в тази форма:

По този начин позволяваме само един PS да индексира сайта. Недостатъкът обаче е, че при използването на този метод все още няма 100% гаранция за неиндексиране. Вкарването на затворен по този начин сайт в индекса обаче е по-скоро изключение.

За да проверите коректността на вашия файл Robots.txt, можете да използвате този инструмент, просто следвайте тази връзка http://webmaster.yandex.ru/robots.xml.

2. Добавяне на Robots Meta Tag

Можете също така да блокирате домейна от индексиране, като добавите етикет към кода на всяка страница:

Къде да напишете МЕТА тага "Роботи". Като всеки META таг, тойтрябва да се постави в областта HEAD на HTML страницата:

Този метод работи по-добре от предишния, толкова по-лесно е да го използвате точково, отколкото опцията с роботи. Въпреки че прилагането му към целия сайт също не е трудно.

3. Затваряне на сайта с .htaccess

За да отворите достъп до сайта само с парола, трябва да добавите към файла .htaccess следния код:

След това достъпът до сайта ще бъде възможен само след въвеждане на паролата.

Защитата срещу индексиране с този метод е сто процента, но има нюанс, с трудността при сканиране на сайта за грешки. Не всички анализатори могат да преминат през процедурата за влизане.

Затваряне на част от текста от индексиране

Много често има такава ситуация, че е необходимо да затворите определени части от съдържанието от индексиране:

Веднага ще кажа, че методът, който беше обичаен по едно време с помощта на етикет, не работи.

Съществува обаче алтернативен метод за затваряне от индексиране, който е много подобен по принцип, а именно методът за затваряне от индексиране с помощта на Javascript.

Затваряне на съдържание от индексиране с Javacascript

Google наистина не одобрява този метод, тъй като винаги е казвал, че трябва да дадете едно и също съдържание на роботи и потребители. И дори изпрати писма в средата на миналата година за необходимостта от отваряне на CSS и JS файлове за индексиране.

В момента обаче това е един от най-ефективните методи за борба с индексирането на неподходящо съдържание.

Как да затворите конкретна страница от индексиране

За да затворите конкретна страница от индекса, най-често се използват следните методи:

- Роботи txt

- Мета роботи noindex

Когапървата опция за затваряне на страницата в този файл, трябва да добавите следния текст:

?По този начин тази страница няма да бъде индексирана с голяма степен на вероятност. Въпреки това, използването на този метод за целенасочена борба срещу страници, които не искаме да дадем за индексиране, не е оптимално.

Така че, за да затворите една страница от индекса, е по-добре да използвате етикета

За да направите това, просто трябва да добавите HTML към областта HEAD на страницата. Този метод ви позволява да не претоварвате файла robots.txt с допълнителни редове.

В крайна сметка, ако трябва да затворите от индекса не 1 страница, а например 100 или 200, тогава ще трябва да добавите 200 реда към този файл. Но това е така, ако всички тези страници нямат общ параметър, по който могат да бъдат идентифицирани. Ако има такъв параметър, те могат да бъдат затворени по следния начин.

Затваряне от индексиране на раздел чрез параметър в URL адреса

Можете да използвате 2 метода за това:

Например, имаме раздел на нашия сайт, който съдържа неуникална информация или информация, която не искаме да дадем за индексиране, и цялата тази информация се намира в 1 папка или 1 раздел на сайта.

След това, за да затворите този клон, е достатъчно да добавите следните редове към Robots.txt:

Можете също да затворите конкретно файлово разширение:

Този метод е доста лесен за използване, но, както винаги, не гарантира 100% неиндексиране.

Следователно, в допълнение, по-добре е да направите още едно затваряне с

Които трябва да се добавят към секцията Head на всяка страница, която трябва да бъде затворена от индекса.

По същия начин можете да затворите всички параметри на вашите URL адреси от индекса, например:

Определено най-простият вариант е да затворите от индексиране с помощта на Robots.txt, но катопрактиката показва, че това не винаги е ефективен метод.

Опасни методи за затваряне на индексиране в robots.txt

Има и доста груб метод за затваряне на нещо от роботи, а именно забрана на ниво сървър за достъп на роботи до конкретно съдържание.

1. Блокирайте всички заявки от нежелани потребителски агенти

Това правило ви позволява да блокирате нежелани потребителски агенти, които могат да бъдат потенциално опасни или просто да претоварят сървъра с ненужни заявки.

В този случай можете да посочите всяка търсачка, анализатор или нещо друго като лош бот.

Подобни техники се използват, например, за да се скрие от робота Ahrefs връзка от сайт, който е създаден/счупен, така че SEO конкурентите да не виждат истинските източници на масата от връзки на сайта.

Този метод обаче си струва да използвате, ако знаете точно какво искате да направите и разумно преценявате последствията от тези действия.

2. Използване на HTTP заглавката на X-Robots-Tag

Хедърът на X-Robots-Tag действа като HTTP хедър елемент за конкретен URL адрес. Всяка директива, която може да се използва в мета маркера robots, се отнася и за X-Robots-Tag.

В X-Robots-Tag директивите могат да бъдат предшествани от името на потребителския агент. Пример за HTTP хедър на X-Robots-Tag, който забранява страницата да бъде показвана в резултатите от търсенето на различни системи.

Заключение

Ситуации, когато е необходимо да затворите съдържание от индексиране, се случват доста често, понякога трябва да почистите индекса, понякога трябва да скриете някои нежелани материали, понякога трябва да хакнете нечий друг сайт и да посочите disalow all в робота, за да изхвърлите огледалния сайт от индекса.

Разгледахме основните и най-ефективни методи, как да ги приложите е въпрос на вашето въображение ицелите, които преследвате.

Отстъпки за начинаещи:

Абонирайте се за интересни актуализации на моя блог, за да сте в тенденцията на най-новите тенденции в разработването и промотирането на уебсайтове: