Как да напишем практическо ръководство

Файлът robots.txt е посредник между вашия сайт и уеб паяците (или роботите за търсене), които редовно посещават вашия ресурс, за да индексират нови и актуализирани страници.

Във всеки (или почти всеки) сайт има страници, които уеб администраторът не би искал да покаже на търсачката. Това могат да бъдат страници с неуникално съдържание, което сте принудени да добавите към сайта (например извадка от закона, условия за програма за отстъпки и т.н.) или страници от админ панел, които системата изобщо не трябва да вижда.

Именно с помощта на robots.txt можете да направите тези нежелани за индексиране страници невидими за търсачката. Robots.txt дава възможност да се забрани индексирането на страници, цели раздели и подраздели на сайта или целия сайт.

Съставяме файла robots.txt правилно

Файлът robots.txt се съхранява в основната папка (директория) на сайта. Има два начина за създаване на файл: самостоятелно (ръчно) и чрез автоматично генериране. начините за автоматично генериране е отделна тема.

Всъщност няма нищо трудно в ръчното компилиране на файл - това просто изисква да сте наясно с основните директиви, които може да се наложи да използвате.

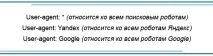

Директива на потребителския агент

Тази директива ТРЯБВА да стартира роботите. Тя е поздрав към вашия сайт от роботите на търсачките.

защото robots.txt има възможност да ограничава или отваря страници на сайта за индексиране отделно за Google или Yandex, User-agent просто съдържа информация за кой от роботите са инструкциите.

Ако директивата User-agent вфайл липсва или не се намира в началото на файла, роботите за търсене ще помислят, че абсолютно всички страници на сайта са отворени за индексиране, включително дори страниците на админ панела.

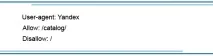

Директиви Allow и Disallow

Директивата Allow позволява страницата/раздела/сайта да бъде индексирана, директивата Disallow, напротив, ограничава достъпа до страници, които не искате да показвате на търсачките.

С помощта на файла robots.txt можете да затворите конкретна директория на сайта от индексиране, като оставите отворени отделни подсекции и страници, включени в нея.

Ако обаче не посочите кои елементи трябва да останат отворени в забранената за индексиране директория, нито един от нейните елементи няма да бъде видим за робота за търсене.

Някои характеристики на файла robots.txt:

- Новата директива е нов ред. Придържайте се стриктно към това правило.

- При писане на директиви е допустимо да се използва само

- За един бот е достатъчна една директива на потребителския агент и всички инструкции могат да бъдат написани в ред.

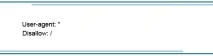

- Символът * (звездичка) може да предотврати индексирането на целия сайт, всички обекти, принадлежащи към определена директория, или всички обекти, съдържащи определена дума.

- Ако затваряте директория от индексиране, символът / (наклонена черта) трябва да бъде както в началото, така и в края на нейното име.

- Ако директивата Disallow няма инструкции, роботътприема това като знак, че целият сайт е отворен за индексиране.

- Указанията за един робот в robots.txt не трябва да се повтарят.

Директива за карта на сайта

Не забравяйте да включите ред във файла robots, указващ къде се намира картата на сайта. Това значително ще ускори индексирането на сайта, а също така ще попречи на робота за търсене да пропуска отделни страници.

Директива за хост

Ако сайтът има огледало (или огледала), директивата Host е записана в robots.txt, което показва кое огледало е основното. Това не гарантира, че търсачката също ще го счита за основно огледало, но значително ще увеличи шансовете.

Важно е да запомните, че директивата Host трябва да идва след директивите Allow и Disallow.

Както можете да видите, писането на файл robots.txt не е толкова трудна наука. Грешките в този файл обаче са доста чести, така че преди да го добавите в главната папка на сайта, използвайте анализатора Yandex robots.txt.

Е, ако имате голям сайт с голям брой директории и ръчното компилиране на robots.txt изглежда като много рисковано начинание, можете да използвате автоматични генератори, за които ще говорим в друга наша статия.

Автор: Анастасия Анненкова, SEO специалист на MSA-IT

Увеличете продажбите на онлайн магазина в 5 стъпки

Видео: Преглед на типовете полета в amoCRM

Типове заявки за търсене: Стойност за промоция