Проблем #167 Как да направите сайта си любим в търсачката

| Проблем #167: Как да направите сайта си любим в търсачката? |

С уважение, Алексей Щарев, главен изпълнителен директор.

Как да направите сайта си "любим" на търсачката?

Разбира се, в България вече има и отдавна работят търсачки, работят върху своите машини, но са много малко, така че още една няма да навреди на никого. И може би дори ще стане по-печеливш от останалите, тъй като има различна политика и добро потребителско покритие - 25-27 милиона души.

Какво притеснява оптимизаторите и уеб администраторите?

Индексиране на целия сайт

Появата на сайта в резултатите от търсенето за определени заявки

Как да постигнете отлично индексиране?Първото правило е да направите вашия сайт възможно най-достъпен за търсачката. Случва се уеб администратори и оптимизатори дори да не знаят, че техният сайт (или някои от страниците му) е блокиран от търсачките. Това може да се случи съвсем случайно, например поради пропуск от страна на системен администратор, който изведнъж не хареса появата на робот за търсене в регистрационните файлове.

След като коригира такъв проблем, търсачката има друг важен въпрос: „Колко страници от сайта да изтеглите?“ Разбира се, уеб администраторът ще ви помоли да изтеглите всичко, но понякога неда познае колко хиляди неизвестни страници има неговият сайт.

Работата е там, че автоматично създаден сайт ви позволява да генерирате неограничен брой URL адреси. Това е технически боклук. Той включва много "невидими" функции:

Облаци от етикети. И тук всичко е добро в умерени количества.

Постер. Емпирично се оказа, че някои плакати могат да се превъртят обратно до 1812 г. и да се разбере, че този ден на екрана не е имало филми.

|

В крайна сметка, ако вземете произволна страница в мрежата, тогава най-често това ще бъде технически боклук - вариант на „крив“ url, направен от небрежен програмист.

Роботите за търсене нямат способността да разберат коя от страниците е необходима и коя се е появила случайно. Следователно определена квота за изтегляне се разпределя за конкретен сайт в зависимост от неговата посещаемост, от разнообразието и полезността на информацията в него.

Адресите се групират автоматично, "регулярните изрази" се събират и се маркират най-интересните сегменти за търсене. Сегментите за архиви и дубликати остават отделни, така че политиката за заобикаляне е гъвкава и постоянно актуализирана.

Всъщност изглежда така: всеки сайт се „хвърля“ в резултатите от търсенето и създава определена картина, която се анализира. Понякога пълният анализ отнема около година.

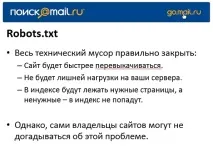

Най-лесният начин да изчистите сайта от техническия боклук е да напишете URL изключения в robots.txt, които в никакъв случай не трябва да влизат в резултатите от търсенето и да го задръстват. Това дава няколко предимства за уеб администратора наведнъж.

|

Ако уеб администраторът на компанията не може да се справи сам, тогава той използва услугите на търсачка: изпраща заявка и получава страница за анализ на сайта с избрани сегменти. И тогава вечесамостоятелно решава какво е необходимо и какво е боклук и трябва да бъде премахнато.

От своя страна е важно за търсачката да разбере дали този метод е помогнал при решаването на проблеми с индексирането или не - необходима е обратна връзка.

Как един сайт да се показва постоянно в резултатите от търсенето?Най-честият въпрос от собствениците на сайтове: къде да купите връзки и колко струват? Несъмнено това е важно, но само след като изберете заявките, за които ще оптимизирате.

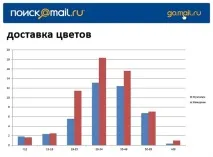

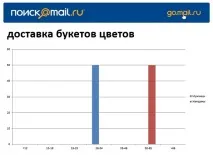

Ако вземем заявки за търсене за доставка на цветя от обикновени потребители от чисти регистрационни файлове, ще открием разлика между две подобни заявки.

|

|

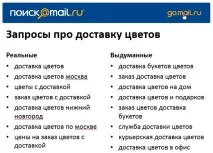

От това става ясно, че „доставка на букети цветя“ е допълнителна заявка. Това е изкуствена заявка, създадена с цел събаряне на позиции. Няма заявки на живо. Честотата е създадена от „фалшив“ трафик, след което огромен брой оптимизатори решиха да преминат към тази заявка. Същите искания включват "доставка на цветя до офиса".

|

Има списък с реални и измислени заявки:

|

Някои може да смятат подобни искания за разреждане, но все пак истинският оптимизатор трябва да си постави за цел да достигне определена позиция в емисията. А изкуствените искания затрудняват достигането на целта. Ето защо търсачките постоянно се борят с тях: поставят captcha, за да филтрират ботове, а във всички останали случаи го оставят в резултатите от търсенето за по-нататъшно проучване.

Създаването на отделен проблем за изкуствени заявки не е включено в плановете на търсачките, въпреки че има много мнения на оптимизатори по този въпрос.

Най-важните фактори за промоцияВисокочестотните и нискочестотните заявки имат много дефиниции. За търсачките високочестотната заявка е заявка, предоставена с поведенческа информация, поради което се класира по-добре от другите. LF заявките са редки заявки, трудно са предвидими и не са подкрепени с никаква информация.

| Изводи |

За да може сайтът да бъде харесан от търсачките и да бъде успешен в издаването, е необходимо тясно взаимодействие между оптимизаторите и специалистите по търсачките. Не отказвайте да получавате допълнителна информация, например важни показатели, които отразяват отношението на потребителите към вашия сайт. Тези данни значително ще улеснят промоцията и ще помогнат да се отървете от очевидни грешки, които на пръв поглед не се виждат.

Преди няколко години Алексей защити докторска дисертация на тема, свързана с извличането на информация, което му позволи не само да стане специалист в партньорската мрежа Admitad, но и да бъде водещ на специализирани семинари. Този път той ще говори за причините за лошото представяне на продуктовите витрини и липсата на индексиране на Yandex; как да направите без бутона "купи"; за скритите функции на новите домейни и факторите, които убиват преобразуването.

Дмитрий Шучалин, ръководител на техническата поддръжка на TrustLink, с право се счита за професионалист в областта на монетизацията на интернет ресурси. Той знае как да накара един сайт да генерира приходи. И той с удоволствие споделя знанията и опита си със заинтересованите слушатели. На семинара ще научите как да изберете домейн, да получите съдържание, да увеличите параметрите и да заобиколите капаните - да не попаднете под филтрите на търсачките.

На уебинара, посветен на генерирането на потенциални клиенти, Данил ще предостави подробно ръководство за действие.Първо, той ще опише общата схема за това как работи генерирането на потенциални клиенти, след това ще се спре по-подробно на източниците на трафик, ще подчертае отделно целевата страница и накрая ще анализира етапите на обработка и квалифициране на потенциални клиенти. Уебинарът ще бъде особено ценен за начинаещи в тази област.

Нови алгоритми на Google TrendsЕкипът на Google Trends, който ви позволява да наблюдавате динамиката на популярните заявки, стартира бета тестване на нови алгоритми. Нововъведението засегна 2 вида заявки: съдържащи думи с множество значения и различни изписвания. В първия случай новите алгоритми сега прецизират заявката, за да филтрират ненужните стойности. Ако фразата или думата за търсене могат да бъдат въведени по различни начини, то Google Trends комбинира всички опции за по-обективна статистика. Тези нововъведения са предназначени да направят услугата по-гъвкава и точна, което, разбира се, трябва да бъде оценено от много специалисти.

|

CPA-арбитражСпециалистът по трафик Александър Кузнецов, наричащ себе си CPA King, говори за трафик арбитраж на прост български език, почти без да използва специална терминология. Той разказа от какви професии хората идват при „арбитражите“, какъв марж може да се счита за приемлив при различни бизнес условия и колко оферти е желателно да има едновременно. Александър успя да събере няколко казуси в един разговор, показвайки ясно как умело да избягвате капаните и лесно да правите бизнес.

Ако Microsoft строеше къщи:

|

Оттогава не му беше лесно на Дядо Коледакак децата попаднаха в интернет